MySQL中导出数据很快,导入到新库时却很慢问题的解决方法

MySQL导出的SQL语句在导入时有可能会非常非常慢,经历过导入仅400万条记录,竟用了近2个小时。在导出时合理使用几个参数,可以大大加快导入的速度。

mysql导出快,导入特别慢的解决方法:

在导入时添加两个参数:max_allowed_packet; net_buffer_length

-e 使用包括几个VALUES列表的多行INSERT语法;

--max_allowed_packet=XXX 客户端/服务器之间通信的缓存区的最大大小;

--net_buffer_length=XXX TCP/IP和套接字通信缓冲区大小,创建长度达net_buffer_length的行

注意:max_allowed_packet和net_buffer_length不能比目标数据库的配置数值大,否则可能出错。

首先确定目标库的参数值

mysql> show variables like 'max_allowed_packet';

+--------------------+---------+

| Variable_name | Value |

+--------------------+---------+

| max_allowed_packet | 1048576 |

+--------------------+---------+

1 row in set (0.00 sec)

mysql> show variables like 'net_buffer_length';

+-------------------+-------+

| Variable_name | Value |

+-------------------+-------+

| net_buffer_length | 16384 |

+-------------------+-------+

1 row in set (0.00 sec)

根据参数值书写mysqldump命令,如:

mysql>mysqldump -uroot -p 数据库名 -e --max_allowed_packet=1048576 -net_buffer_length=16384 > SQL文件

例如:

1.mysql> mysqldump -uroot -p xjtrace -e --max_allowed_packet=1048576 --net_buffer_length=16384 >xjtrace_data_`date +%F`.sql

之前2小时才能导入的sql现在几十秒就可以完成了。

其它列子分析:

XX市邮政微商城的项目数据库,300多M,约220万条数据,source命令导入花了20个小时左右,太不可思议。

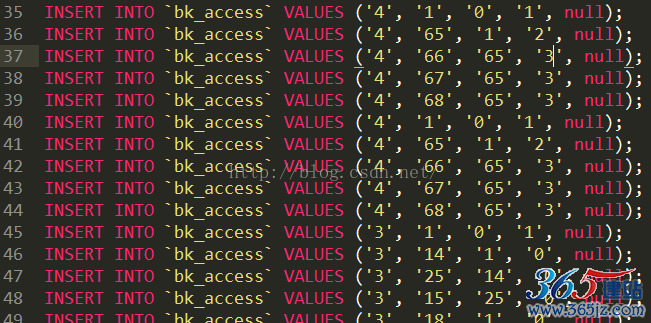

速度慢原因:220多万条数据,就 insert into 了220多万次,下图:

这是用 navicat 导出来的数据结构。

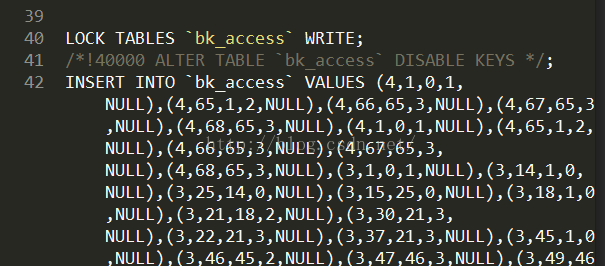

后面用 mysqldump 工具导出,唯一区别是insert into方式不一样,如下图:

重新导入测试,仅仅用了不到2分钟。

另外,source命令在导入时,如果一次性插入的数据太多,mysql会自动优化,拆开多次插入。如在导入时发现,一张表有100万左右数据,它每次插入是1万多条;另外一张表是1万多数据,它也拆开成2次插入。

如对本文有疑问,请提交到交流论坛,广大热心网友会为你解答!! 点击进入论坛