几款常用的免费web网站日志分析工具推荐

网站的SEO优化过程中不免会分析网站日志,网站日志的分析和诊断就像给网站看病一样,我们通过网站日志的分析,可以更加清楚的知道网站的健康状况,使用这些数据更有利于开展网站SEO优化。网络管理员如果想在企业的大型网络中掌握网络性能,离不开对网络日志的分析,帮助你在网络性能出现问题时,及早发现。

通过网站日志可以清楚的得知用户在什么IP、什么时间、用什么操作系统、什么浏览器、什么分辨率显示器的情况下访问了你网站的哪个页面,是否访问成功。对于专业从事搜索引擎优化工作者而言,网站日志可以记录各搜索引擎蜘蛛机器人爬行网站的详细情况,例如:哪个IP的百度蜘蛛机器人在哪天访问了网站多少次,访问了哪些页面,以及访问页面时返回的HTTP状态码。

为什么需要日志分析工具?

连接到网络的每个设备或应用都会创建日志文件。网络管理员使用这些日志文件来查看性能数据。这些工具很有用,因为它们提供了对用户本来不具备的数据的访问权限。日志分析工具从设备的日志文件中收集数据,并将其转换为易于阅读的格式。在日志分析工具中,以图形将性能的相关数据显示到仪表盘。以这种集中格式,读取性能数据要比尝试直接读取日志文件作为文本文件容易得多。

常见的蜘蛛名称:

Baiduspider:百度蜘蛛

Baiduspider-Image:百度图片蜘蛛

Googlebot:谷歌机器人

Googlebot-Image:谷歌图片机器人

360Spider:360蜘蛛

sogou spider:搜狗蜘蛛

一、网站日志的作用

1、通过网站日志可以了解蜘蛛对网站的基本爬取情况,可以知道蜘蛛的爬取轨迹和爬取量。

2、网站的更新频率也和网站日志中蜘蛛抓取的频率有关,一般来说更新频率越高,蜘蛛的抓取频率越高,而我们网站的更新不仅仅只是新内容的添加同时还有我们的微调操作。

3、我们可以根据网站日志的反应情况,对我们的空间的某些事情和问题提前进行预警,因为服务器如果出问题的话在网站日志中会第一时间反映出来,要知道服务器的稳定速度和打开速度两者都会直接影响我们的网站。

4、通过网站日志我们可以知道网站的那些页面是很受蜘蛛欢迎的,而哪些页面是蜘蛛连碰都不去碰的,同时我们还能发现有一些蜘蛛由于是过度爬取对我们的服务器资源损耗是很大的,我们要进行屏蔽工作。

二、如何下载网站日志

1、首先我们的空间要支持网站日志下载,这一点是很重要的,在购买空间时候需事先了解下是否支持日志下载,因为有的服务商是不提供这项服务的,如果支持的话空间后台一般都有日志WebLog日志下载这个功能把它下载到根目录在用FTP传到本地就可以,服务器的话可以设置将日志文件下载到指定路径。

2、这里有个很重要的问题,网站日志强烈建议设置成每小时生成一次,小型的企业站和页面内容较少的网站可以设置成一天,它默认是一天,如果内容多或者大型站设置成一天生成一次,那么一天只生成一个文件,这个文件会相当的大,我们有时电脑打开是会造成死机,设置的话找空间商协调设置即可。

三、网站日志数据分析

1、网站日志中数据量过大,所以我们一般需要借助网站日志分析工具来查看。常用的日志分析工具有:光年日志分析工具、web log exploer、WPS表格等

117.26.203.167 - - [02/May/2011:01:57:44 -0700] "GET/index.php HTTP/1.1" 500 19967 "-" "Mozilla/4.0 (compatible; MSIE 8.0;Windows NT 5.1; Trident/4.0; AskTbCS-ST/5.11.3.15590; .NET CLR 2.0.50727; Alexa Toolbar)"

分析:

117.26.203.167访问ip;

02/May/2011:01:57:44 -0700访问日期 -时区;

GET/index.php HTTP/1.1根据HTTP/1.1协议抓取(域名下)/index.php这个页面(GET表示服务器动作);

500服务器响应状态码;

服务器响应状态码通常状态码有以下几种:200,301,302,304,404,500等。200代表用户成功的获取到了所请求的文件,如果是搜索引擎,则证明蜘蛛在这次爬行中顺利的发现了一些新的内容。而301则代表用户所访问的某个页面url已经做了301重定向(永久性)处理,302则是暂时性重定向。404则代表所访问的页面已经不存在了,或者说访问的url根本就是个错误的。500则是服务器的错误。

19967表示抓取了19967个字节;

Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 5.1; Trident/4.0; AskTbCS-ST/5.11.3.15590; .NET CLR 2.0.50727; Alexa Toolbar表示访问者使用火狐浏览器及Alexa Toolbar等访问端信息;

2、如果你的日志里格式不是如此,则代表日志格式设置不同。

3、很多日志里可以看到 200 0 0和200 0 64则都代表正常抓取。

4、抓取频率是通过查看每日的日志里百度蜘蛛抓取次数来获知。抓取频率并没有一个规范的时间表或频率数字,我们一般通过多日的日志对比来判断,当然,我们希望百度蜘蛛每日抓取的次数越多越好。

5、有时候我们的路径不统一出现带斜杠和不带斜杠的问题,蜘蛛会自动识别为301跳转到带斜杠的页面,这里我们就发现了搜索引擎是可以判断我们的目录的,所以我们要对我们的目录进行统一。

6、我们分析日志分析时间长了,我们能够看出蜘蛛的抓取规律,同一目录下面的单个文件的抓取频率间隔和不同目录的抓取频率间隔都可以看出来,这些抓取频率间隔时间是蜘蛛根据网站权重和网站更新频率来自动确定的。

7、蜘蛛对于我们的页面的抓取是分等级的,是根据权重依次递减的,一般顺序为首页、目录页、内页。

四、通过网站日志我们能知道什么?

1、我们买的空间是否能够稳定?

2、蜘蛛对我们的那些页面比较喜欢而对哪些不喜欢?

3、蜘蛛什么时候抓取我们的网站频繁,我们需要什么时候更新内容?

总结:所以不管是新站还是老网站,不管你做百度还是Google我们都能通过网站日志分析出来搜索引擎蜘蛛抓取的情况;如果网站长时间收录有问题,那么我们也可以对比网站日志中的搜索引擎蜘蛛行为,来了解网站是哪方面出了问题;如果网站被封,或者被K,我们都可以通过观察网站日志的情况来了解原因出在什么地方。我们要看的网站日志的分析和诊断就像给网站看病一样,我们通过网站日志的分析,可以简单明了的就知道网站的健康状况,可以利于我们更好的做网站优化,所以对于真正的SEO高手而言,分析蜘蛛日志是最直观,最有效的额。

服务器日志分析软件或者在线工具,都是根据我们常用的WEB环境导出或者在线生成的LOG日志文件,然后进行的可视化数据分析。会区别开各个时间节点,访客、爬虫的行为,有些基础的用户可能在需要的时候看看LOG日志文件就可以,如果深入分析的话会需要一款辅助的日志分析工具。

五、网站日志分析工具推荐

1、Webalizer

Webalizer,采用C语言编写的,具有很高的运行效率,每秒钟可以分析10000条数据记录。有人进行测试过,如果分析40M的日志文件,只需要十几秒。Webalizer日志工具是一款高效的、免费的web服务器日志分析程序。

Webalizer日志工具会将分析结果以HTML文件格式保存,我们可以很方便的通过web进行浏览,webalizer支持标准的一般日志文件格式(Common Logfile Format)。

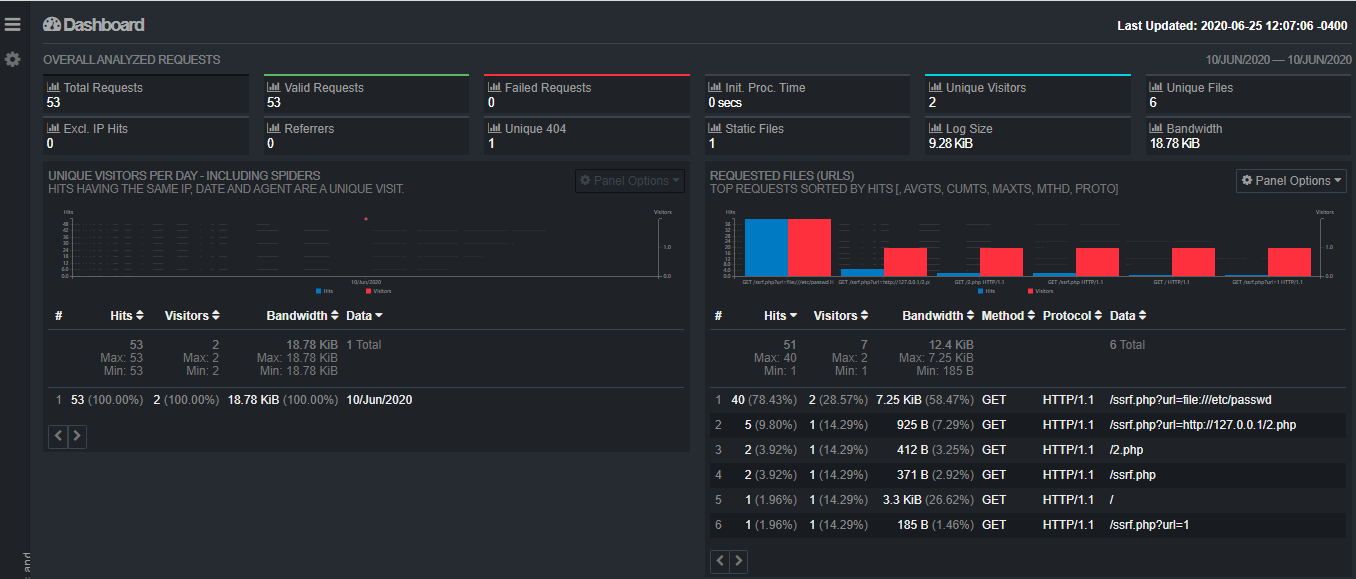

2、GoAccess

GoAccess,一款来自国外的免费开源可部署在服务器端实现实时日志分析的工具。而且GoAccess日志分析可以实现实时可视化WEB显示,这个优秀的交互功能比有些仅仅是数据化显示更为体验友好。GoAccess可以实现WEB浏览器端HTML、CSV、JSON报告,比较适合有需要强化运维能力和数据分析的项目。

GoAccess采用C语言编写,可实现毫秒级的更新,支持Apache, Nginx, Amazon S3, Elastic Load Balancing, CloudFront等WEB日志格式。可以实现漂亮的终端以及 bootstrap 风格控制面板。在这篇文章中,笔者就和大家一起探索GoAccess日志软件的部署和功能。

一款可视化 Web 日志分析工具,通过Web 浏览器或者 nix 系统下的终端程序即可访问。能为系统管理员提供快速且有价值的 HTTP 统计,并以在线可视化服务器的方式呈现。

官网地址:https://www.goaccess.cc/

3、Analog

Analog,也是一款用来快速处理日志的开源日志分析工具。同样具有很高的效率,不过这款工具生成的日志结果不够美观,analog可以读取gz格式压缩的日志文件,并且支持读取多个文件。Analog下载安装和进行必要配置后,直接运行analog即可,也可以指定相应的启动参数来改变输出文件的内容块。一般地,会使用crontab来设置一个指定的时间去运行该程序。

4、LOGalyze

LOGalyze,一款来自国外的面向用户的开源服务器日志和监控日志工具。支持Windows和Linux系统,可以用于收集数据之后,然后针对程序搜索找到所需要的信息。一般这款工具国外的使用的多,但是感觉不是太适合我们国内用户的使用习惯。

LOGalyze 配置过程也稍微复杂一些,然后我们在 LOGalyze 的 Web 界面中,运行动态报告,并将其导出到 Excel 文件、PDF 文件或其他格式。这些报告结果是基于 LOGalyze 后端管理的多维统计信息。

5、Papertrail

Papertrail,是一款Windows系统的日志分析软件工具。软件可以支持自动扫描日志数据。Papertrail扫描日志数据时,可以选择希望扫描结果显示的信息。例如,可以选择扫描是否包含IP地址,电子邮件地址, GUID/UUID,HTTP(s)URL,域,主机,文件名和引用文本等。

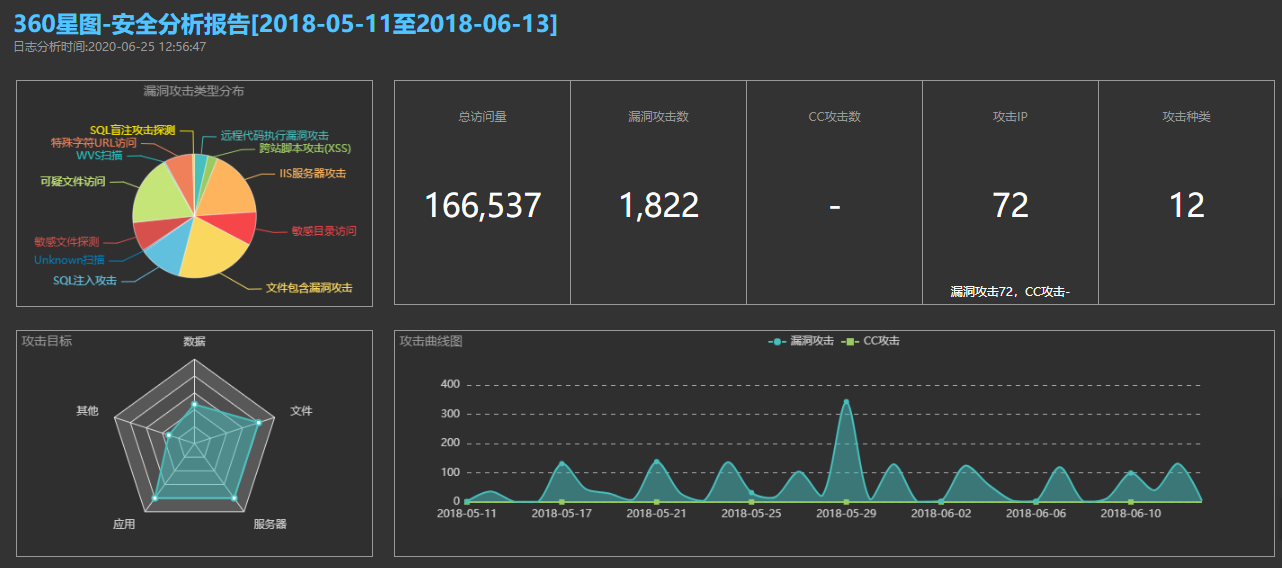

6、360星图

一款非常好用的网站访问日志分析工具,可以有效识别Web漏洞攻击、CC攻击、恶意爬虫扫描、异常访问等行为。一键自动化分析,输出安全分析报告,支持iis/apache/nginx日志,支持自定义格式。

下载地址:https://wangzhan.qianxin.com/activity/xingtu

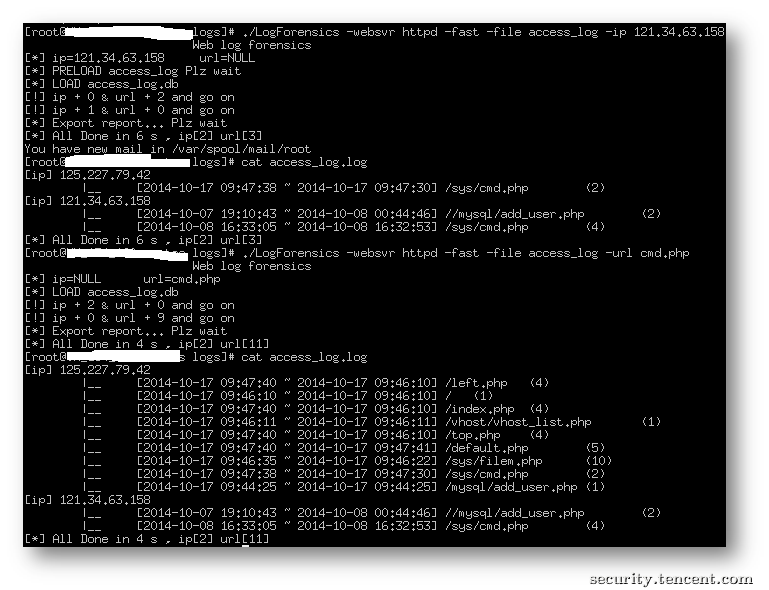

7、LogForensics

TSRC提供的一款日志分析工具,可从单一可疑线索作为调查起点,遍历所有可疑url(CGI)和来源IP。

相关下载地址:https://security.tencent.com/index.php/opensource/detail/15

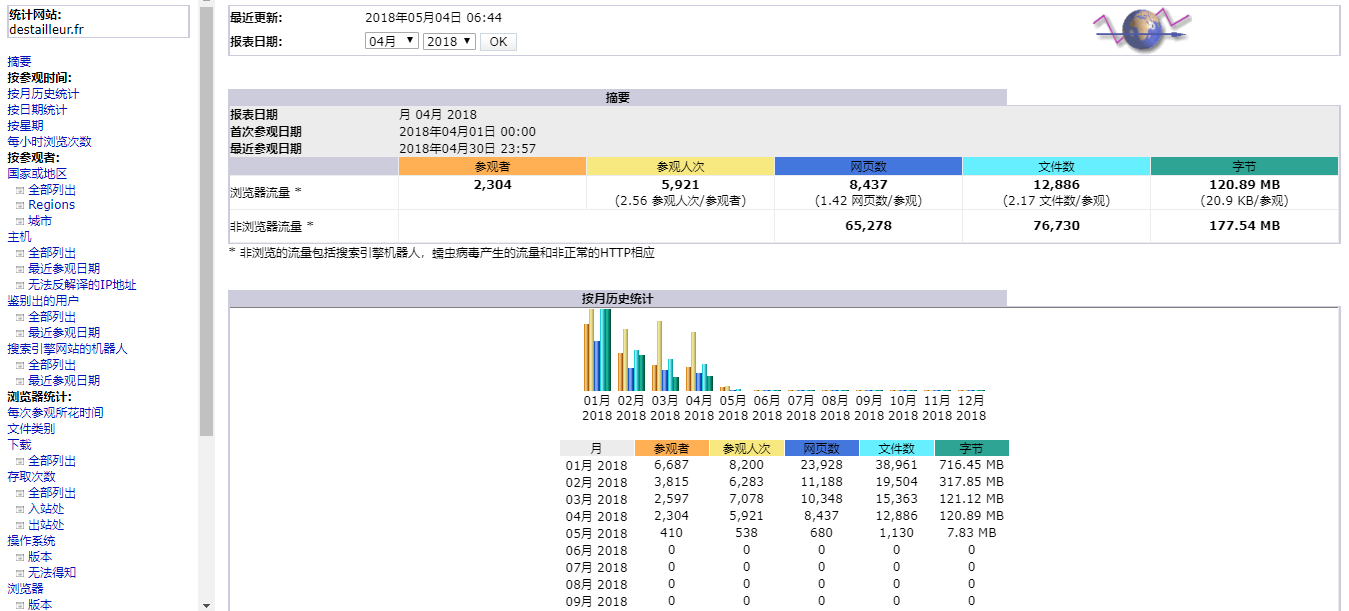

8、AWStats

8、AWStats

一款功能强大的开源日志分析系统,可以图形方式生成高级Web,流媒体,ftp或邮件服务器统计信息。

官网地址:http://www.awstats.org/

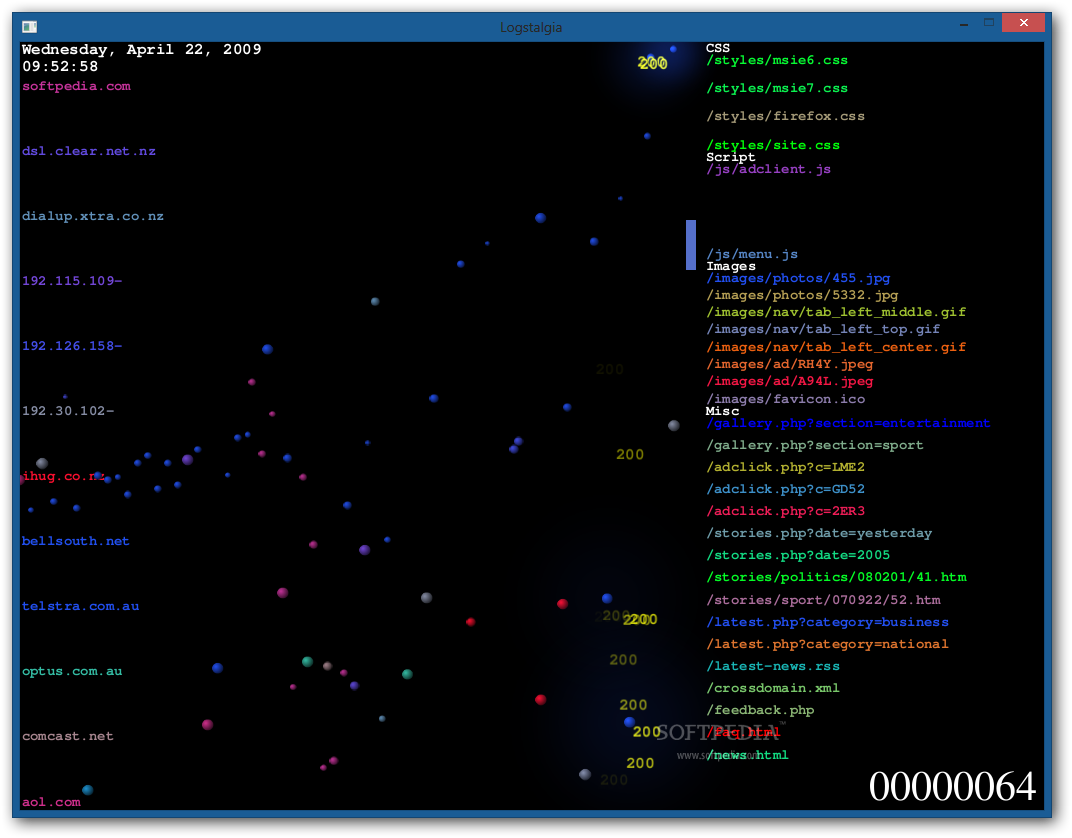

9、Logstalgia

一款非常炫酷且可视化日志分析工具,可以直观的展示CC攻击和网站的日志分析,并以可视化的3D效果展示出来。

下载地址:http://www.softpedia.com/get/Internet/Servers/Server-Tools/Logstalgia.shtml

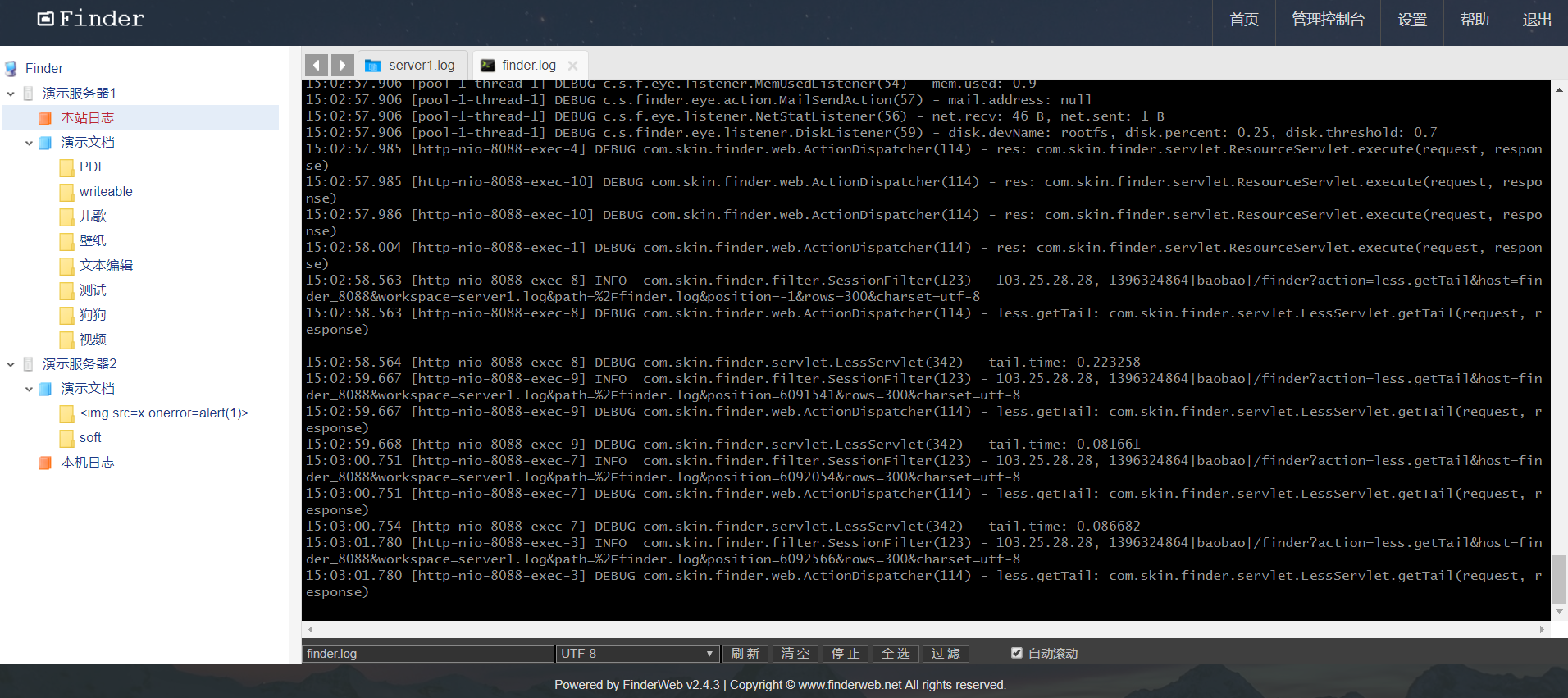

10、FinderWeb

程序员的看日志利器,支持,tail, less, grep,支持超大的文本文件,从几M到几十G的日志文件都流畅自如。

下载使用:http://www.finderweb.net/download.html

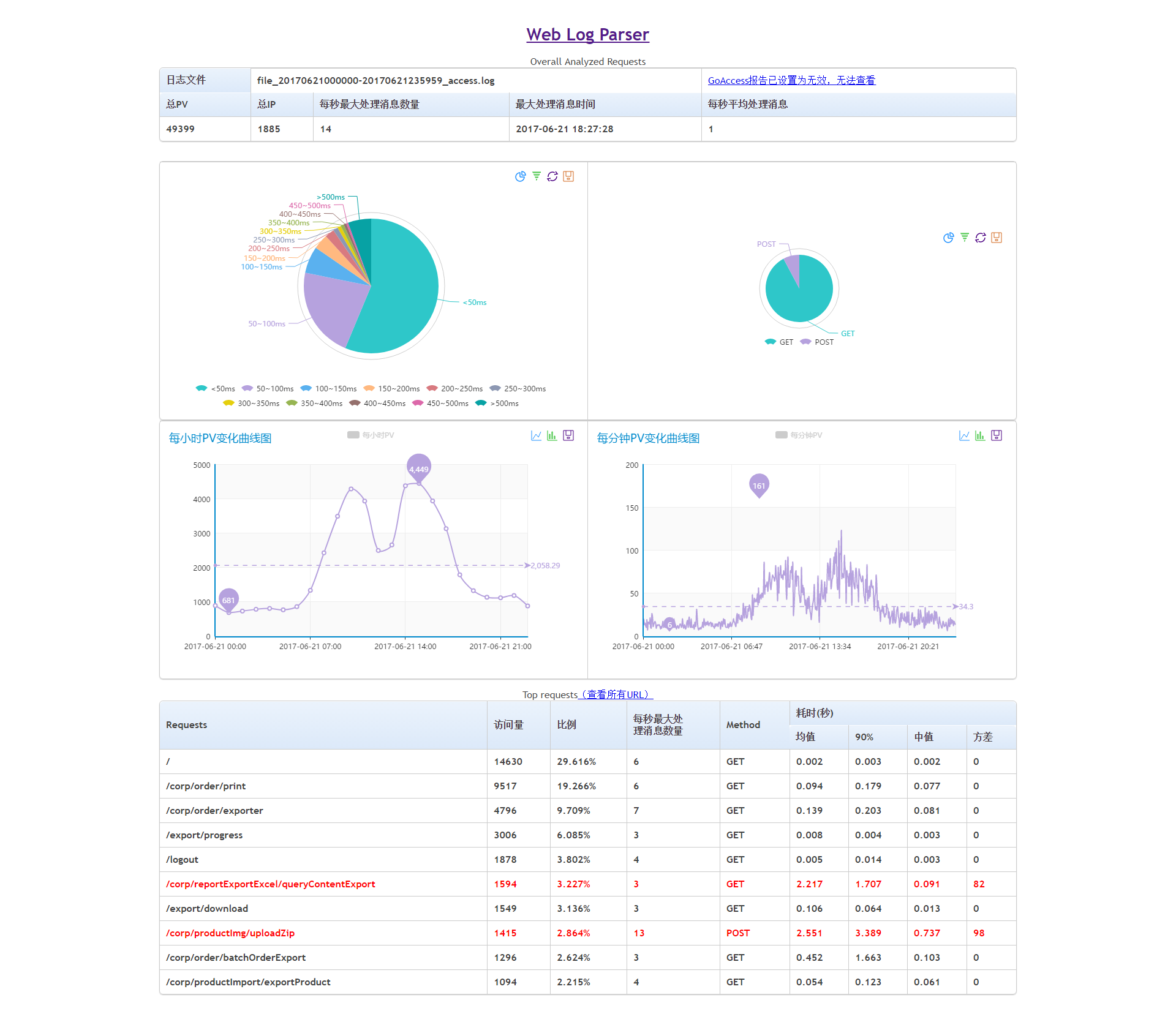

11、web-log-parser

一款开源的分析web日志工具,采用python语言开发,具有灵活的日志格式配置。

github项目地址:https://github.com/JeffXue/web-log-parser

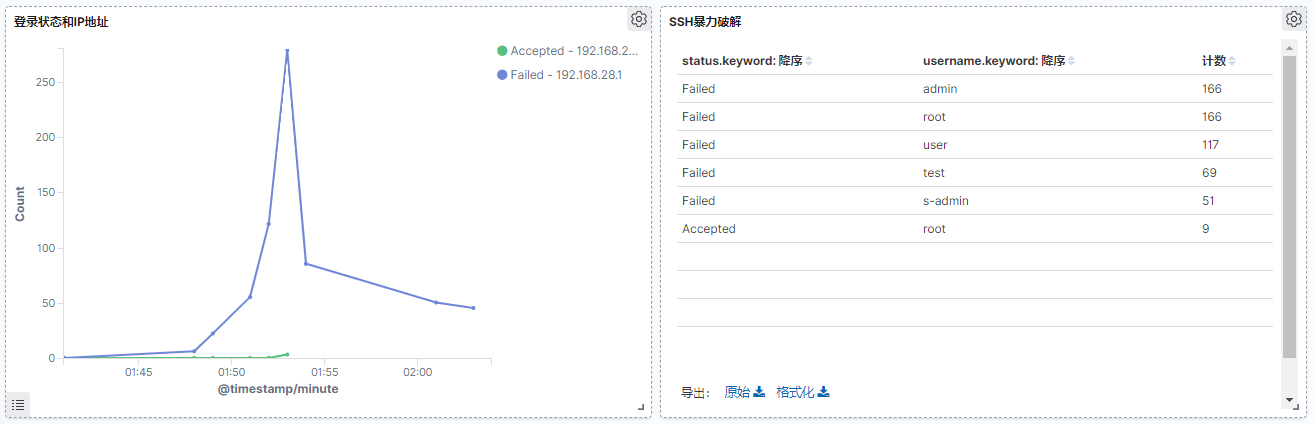

12、ELK

开源实时日志分析的ELK平台,由ElasticSearch、Logstash和Kiabana三个开源项目组成,在企业级日志管理平台中十分常见。

下载使用:https://www.elastic.co/cn/elastic-stack

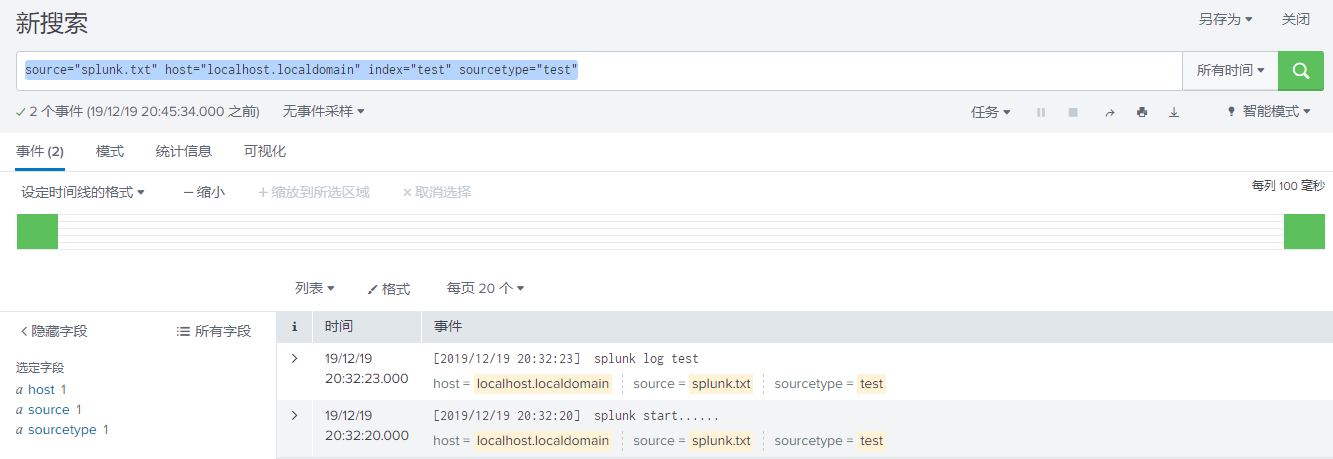

13、Splunk

一款顶级的日志分析软件,如果你经常用 grep、awk、sed、sort、uniq、tail、head 来分析日志,那么你可以很容易地过渡到Splunk。

下载地址:https://www.splunk.com/zh-hans_cn/download/splunk-enterprise.html

14、IBM QRadar

Qradar有一个免费的社区版本,功能上和商用版本差别不大,适合小规模日志和流量分析使用。

下载地址:https://developer.ibm.com/qradar/ce/

总结,我们一般站长也很少日常去分析日志,即便需要使用也是在出现故障的时候去看。不过目前也有一些WEB环境自带插件是支持可用日志分析的,比如会看看搜索引擎爬虫的日志和用户行为日志。

如对本文有疑问,请提交到交流论坛,广大热心网友会为你解答!! 点击进入论坛